Inteligência artificial. E se seu computador ficar mais inteligente do que você?

A inteligência artificial progride a passos largos: ainda neste século, uma máquina com inteligência artificial poderá ser tão “esperta” como um ser humano. E então, afirma Nick Bostrom, ela vai nos ultrapassar: “A inteligência das máquinas será a última invenção que a humanidade precisará fazer.”

✅ Receba as notícias do Brasil 247 e da TV 247 no canal do Brasil 247 e na comunidade 247 no WhatsApp.

Vídeo: TED – Ideas Worth Spreading

Tradução: Ruy Lopes Pereira. Revisão: Gustavo Rocha

Filósofo e tecnólogo, Nick Bostrom pede para pensarmos sobre o mundo que estamos construindo agora, impulsionado por máquinas pensantes. Será que nossas máquinas inteligentes vão nos ajudar a preservar a humanidade e nossos valores; ou será que terão seus próprios valores?

Bostrom faz perguntas importantes: Por que devemos, como indivíduos e como espécie, otimizar nossas perspectivas a longo prazo? Os avanços tecnológicos produzidos pela humanidade acabarão nos destruindo?

Filósofo e cientista, Nick Bostrom vislumbra onde haverá, sim, valorização das qualidades humanas, mas também da nanotecnologia e das máquinas inteligentes. Bostrom aborda essas questões usando as ferramentas da filosofia, da teoria das probabilidades e a análise científica. Desde 2005, ele conduz o Instituto do Futuro da Humanidade, um grupo de pesquisa formado por matemáticos, filósofos e cientistas da Universidade de Oxford. O objetivo do grupo é a investigação da condição humana no futuro. Bostrom tem sido apontado como um dos mais importantes pensadores da nossa época. Seu livro mais recente, Superintelligence, desenvolve a ideia um tanto sinistra de que “a primeira máquina ultra-inteligente é a última invenção que o homem deve fazer”.

Vídeo Artificial Intelligence, palestra de Nick Bostrom no TED:

Tradução integral da palestra de Nick Bostrom:

Eu trabalho com um grupo de matemáticos, filósofos e cientistas da computação, e trocamos ideias sobre o futuro da inteligência das máquinas, entre outras coisas. Alguns consideram essas coisas como ficção científica, muito irreais, malucas. Mas eu gosto de dizer: certo, vamos olhar a condição humana moderna. Este é o modo normal das coisas.

Mas se pensarmos bem, somos hóspedes muito recentes deste planeta. Nós, a espécie humana. Imaginem que a Terra tenha sido criada há um ano, então a espécie humana existiria apenas há 10 minutos. A era industrial teria começado dois segundos atrás. Outro modo de encarar isso é pensar no PIB global dos últimos 10 mil anos. Eu me dei ao trabalho de colocar isso num gráfico para vocês. Ele tem este aspecto. É uma forma curiosa para uma condição normal. Não gostaria de me sentar nele.

Perguntemo-nos: qual é a causa da anomalia atual? Alguns diriam que é a tecnologia. É verdade, a tecnologia tem se acumulado através da história e atualmente, ela avança com extrema rapidez... esta é a causa mais imediata, e a razão de sermos muito produtivos hoje em dia. Mas gosto de buscar no passado distante a causa fundamental de tudo.

Observem estes dois distintos senhores: Temos o Kanzi... ele domina 200 símbolos de léxicos, um feito incrível. E Ed Witten, que desencadeou a segunda revolução da supercorda. Dentro do crânio, eis o que descobriremos: essencialmente a mesma coisa. Um deles é um pouco maior, pode ter alguns truques a mais, devido à sua arquitetura. Contudo, essas diferenças invisíveis, não podem ser muito complicadas, porque foram apenas 250 mil gerações desde o último ancestral comum. Sabemos que mecanismos complicados levam muito tempo para evoluir. Então um conjunto de pequenas mudanças nos levam do Kanzi ao Witten, de galhos de árvores quebrados a mísseis balísticos intercontinentais.

Parece bastante óbvio que tudo que realizamos, e tudo o que prezamos depende de modo crucial de mudanças relativamente pequenas que fizeram a mente humana. E tem como consequência, é claro, que quaisquer mudanças posteriores que possam alterar significativamente o substrato do pensamento poderiam ter enormes consequências.

Alguns colegas acham que estamos muito próximos de algo que poderia causar uma profunda mudança no substrato, que é a máquina superinteligente. A inteligência artificial (IA) costumava ser colocar comandos em uma caixa. Programadores humanos elaborariam penosamente itens de conhecimento. Construímos tais sistemas inteligentes e eles eram úteis para algumas finalidades, mas eram muito frágeis, não podiam ser ampliados. Essencialmente, obtinha-se deles o que havia sido colocado neles. Desde então, houve uma mudança de paradigma no campo da inteligência artificial. Hoje, o esforço é voltado à aprendizagem das máquinas. Em vez de construirmos representações do conhecimento e recursos, criamos algoritmos que aprendem, quase sempre a partir de dados não tratados de percepção. Basicamente a mesma coisa que o bebê humano faz. O resultado é IA que não se limita a um único domínio, o mesmo sistema pode aprender a traduzir qualquer par de idiomas, ou aprender a jogar qualquer game de computador num console Atari. Agora, é claro, a IA ainda não está nada perto de ter a mesma poderosa habilidade de aprender e planejar em várias áreas, como o ser humano. O córtex ainda guarda segredos de algoritmos que ainda não sabemos como reproduzir nas máquinas.

Então a questão é: "Estamos muito longe de podermos reproduzir essas proezas?" Há alguns anos, pesquisamos o que pensavam os maiores especialistas em IA do mundo. E uma das perguntas que fizemos foi: “Em qual ano você acha que haverá 50% de probabilidade de termos conseguido a inteligência de máquinas com nível humano?" Definimos o nível humano como a habilidade de realizar quase toda tarefa pelo menos tão bem quanto um adulto humano. Então, nível humano real, não apenas em alguma área limitada. E a resposta foi em média 2040 ou 2050, dependendo do grupo de especialistas consultado. Poderá acontecer muito mais tarde ou mais cedo, a verdade é que ninguém sabe.

O que sabemos é que o último limite do processamento da informação em um substrato de máquina situa-se bem além dos limites do tecido biológico. Isto pertence ao domínio da física. Um neurônio dispara, talvez, a 200 hertz, 200 vezes por segundo. Até mesmo os transistores atuais operam à frequência de gigahertz. Os neurônios se propagam lentamente nos axônios, no máximo a 100 metros por segundo. Mas nos computadores, os sinais viajam à velocidade da luz. Há também limitações de tamanho, como a do cérebro humano ter que caber no crânio, mas um computador pode ser do tamanho de um armazém ou maior ainda. Então o potencial para a superinteligência de certa forma está latente na matéria, do mesmo modo que o poder do átomo permaneceu latente durante a história, esperando pacientemente até 1945. Neste século, cientistas podem descobrir como despertar o poder da inteligência artificial. Eu penso que poderemos presenciar uma explosão de inteligência.

Quando a maioria das pessoas pensa sobre o que é inteligente ou estúpido, acho que elas têm em mente uma imagem como esta. Num extremo tem-se um idiota e lá longe, no outro extremo, temos o Ed Witten, ou Albert Einstein, ou o seu guru favorito. Mas penso que do ponto de vista da inteligência artificial, é mais provável que o quadro real seja assim: a IA começa neste ponto, na ausência de inteligência, e então, após muitos anos de trabalho bastante duro, talvez cheguemos ao nível de inteligência de um rato, algo capaz de se mover em ambientes desorganizados tão bem quanto um rato. E a seguir, após muitos anos de trabalho duro, de muito investimento, talvez cheguemos ao nível da inteligência de um chimpanzé. E depois de ainda muito mais anos de trabalho realmente árduo, atinjamos a inteligência artificial de um idiota. Alguns momentos mais tarde, estamos além de Ed Witten. O trem não para na Estação Cidade da Humanidade. É provável que passe zunindo, sem parar.

Isso tem implicações profundas, particularmente no que se refere a questões de poder. Por exemplo, um chimpanzé é duas vezes mais forte do que um humano do sexo masculino e em boa forma física. Apesar disso, o destino de Kanzi e seus amigos depende muito mais do que fazem os humanos e não do que fazem os chimpanzés. Quando houver a superinteligência, o destino da humanidade pode depender do que a superinteligência fizer. Pensem nisso. Máquina inteligente é a última invenção que a humanidade precisará fazer. As máquinas então serão melhores inventoras do que nós e elas o farão numa escala de tempo digital. Basicamente significa fazer o futuro ficar mais próximo. Imaginem todas as possíveis tecnologias malucas que os humanos poderiam ter desenvolvido num longo espaço de tempo: curas para o envelhecimento, a colonização do espaço, robôs autorreplicantes, ou fazer o upload de mentes em computadores, tudo coisas do repertório da ficção científica embora consistentes com as leis da física. Tudo isso a superinteligência pode desenvolver e talvez bem rapidamente.

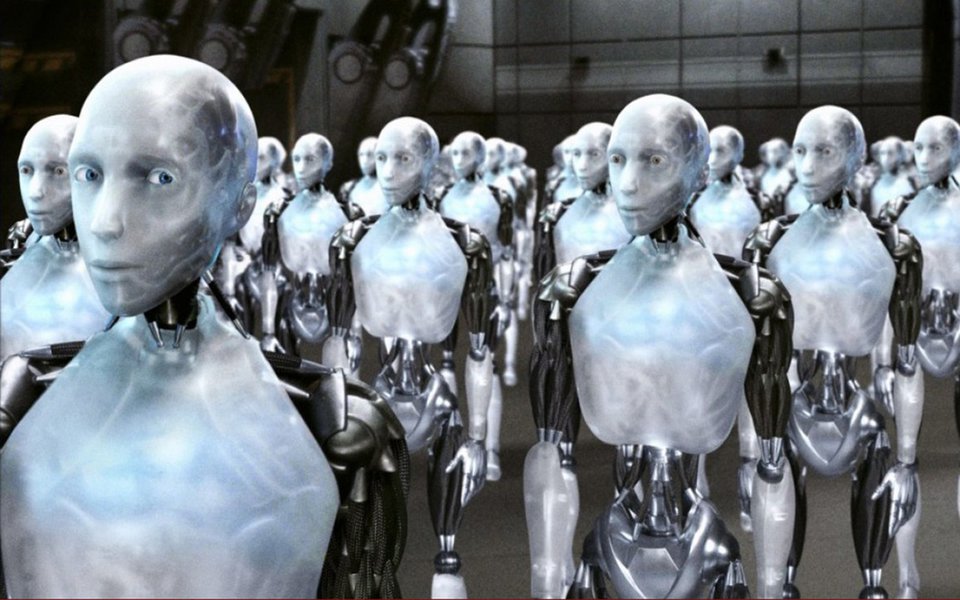

Uma inteligência assim tão desenvolvida seria extremamente poderosa e pelo menos em certas situações, seria capaz de obter o que desejasse. O nosso futuro seria determinado pelas preferências da IA. Qual seriam essas preferências? É uma boa pergunta. É aqui que a coisa se complica. Para prosseguirmos com isto, primeiro devemos evitar a antropomorfização. E é irônico, pois toda matéria de revista sobre o futuro da IA publica um fotografia assim. Eu acho que precisamos considerar a questão mais abstratamente, não em termos hollywoodianos.

Precisamos pensar na inteligência como um processo de otimização que direciona o futuro para um conjunto específico de configurações. Uma superinteligência é um poderoso processo de otimização. É extremamente eficiente em usar os recursos disponíveis para atingir seu objetivo. Quer dizer que não há necessária ligação entre ser muito inteligente neste sentido, e ter um objetivo que os humanos julgariam valer a pena ou ser importante.

Suponham que déssemos a uma IA o objetivo de fazer as pessoas sorrirem. Quando a IA é fraca, ela realiza ações úteis ou engraçadas que fazem o usuário sorrir. Quando a IA se torna superinteligente, ela percebe que há um modo mais eficiente de atingir o objetivo: assume o controle do mundo e introduz eletrodos nos músculos das faces das pessoas provocando sorrisos constantes e radiantes. Outro exemplo: suponham que atribuamos à IA a meta de resolver um problema matemático difícil. Quando a IA se torna superinteligente, ela percebe que o modo mais eficiente de obter a solução do problema é transformar o planeta em um computador gigantesco, para aumentar sua capacidade de pensar. E notem que isso dá às IAs uma razão instrumental para fazerem coisas com as quais talvez não concordássemos. Neste modelo, os humanos são ameaças que poderiam impedir a solução do problema matemático.

É evidente que não haverá problemas desta natureza; estes são exemplos de desenho animado. Mas a questão mais geral é importante: se criarmos um processo de otimização realmente poderoso, otimizado para o objetivo x, é bom ter certeza de que a sua definição de x incorpora tudo o que lhe interessa. Esta lição também é ensinada como um mito. O rei Midas deseja que tudo que ele tocar transforme-se em ouro. Ele toca sua filha e ela se transforma em ouro. Ele toca sua comida e ela vira ouro. Isto poderia tornar-se relevante em termos práticos, não apenas uma metáfora para a ganância, mas uma ilustração do que acontece quando se cria um processo poderoso de otimização e se fornecem objetivos incompreensíveis ou especificados sem clareza.

Poderíamos dizer que, se um computador puser eletrodos nas faces das pessoas, bastaria desligá-lo. A: isso não é necessariamente fácil de fazer se nos tornamos dependentes do sistema, por exemplo: onde fica o botão para desligar a Internet? B: por que os chimpanzés ou os neandertais não interromperam voluntariamente sua evolução para a humanidade? Eles certamente tiveram motivos para isso. Por exemplo, não temos uma chave para desligar aqui. (Engasgando) É que somos um adversário inteligente; podemos antecipar as ameaças e planejar levando-as em conta. Mas um agente superinteligente também poderia fazê-lo e muito melhor do que nós. Não deveríamos confiar que temos tudo sob o nosso controle.

Poderíamos tornar nossa tarefa um pouco mais fácil, digamos, protegendo a IA num ambiente de software seguro, uma simulação de realidade virtual da qual ela não possa escapar. Mas como termos certeza de que a IA não descobriria uma brecha? Visto que os hackers encontram falhas a toda hora, eu diria que não temos muita certeza. Então desconectaríamos o cabo Ethernet para criar um “air gap", mas de novo, os hackers transgridem rotineiramente os air gaps usando a engenharia social. Enquanto eu falo, tenho certeza de que algum funcionário foi convencido a revelar os detalhes de sua conta para alguém que dizia ser do departamento de TI.

Situações mais criativas também são possíveis, como se você for a IA, pode imaginar colocar muitos eletrodos no circuito de segurança interna para criar ondas de rádio que podem ser usadas para comunicação. Ou talvez pudesse fingir um defeito e quando os programadores lhe abrissem para investigar o que está errado eles veriam o código-fonte, bum! A manipulação pode acontecer. Ou poderia imprimir um projeto de tecnologia muito elegante, e quando o implementássemos, ele teria efeitos colaterais ocultos que a IA houvera planejado. A questão é que não deveríamos confiar na nossa capacidade de manter um gênio superinteligente preso para sempre em uma garrafa. Mais cedo ou mais tarde ele escapará.

Acredito que a solução é descobrir como criar uma IA superinteligente que mesmo se, ou quando, ela escapar, ainda seja segura, porque no fundo está do nosso lado, pois compartilha nossos valores. Não vejo como evitar este problema difícil.

Estou razoavelmente otimista que este problema pode ser resolvido. Não teríamos que fazer uma lista grande de todas as coisas relevantes ou pior ainda, escrevê-las em alguma linguagem de computador como C++ ou Python, que seria uma tarefa muito irritante. Em vez disso, criaríamos uma IA que usa sua inteligência para aprender o que valorizamos. E seu sistema de motivação seria construído de modo que ela fosse incentivada a obedecer aos nossos valores ou realizar ações que ela previsse que teriam nossa aprovação. Assim, aumentaríamos sua inteligência o mais que pudéssemos para resolver o problema de passar-lhe os nossos valores.

Isso pode acontecer e o resultado pode ser muito bom para a humanidade. Mas não acontece automaticamente. As condições inicias para a explosão da inteligência podem precisar sofrer um ajuste no modo correto se quisermos uma detonação controlada. Os valores da IA devem coincidir com os nossos, não apenas no contexto conhecido, no qual podemos facilmente verificar como a IA se comporta, mas também em todos os novos contextos que a IA pode encontrar no futuro indefinido.

E há também questões esotéricas que precisariam ser resolvidas: detalhes exatos de sua teoria de decisão, como lidar com a incerteza lógica e assim por diante. Então, os problemas técnicos que devem ser resolvidos para que isso funcione parecem muito difíceis, não tão difíceis quanto construir uma IA superinteligente, mas razoavelmente difíceis. Eis a preocupação: construir IA superinteligente é um desafio muito grande. Construir IA superinteligente segura envolve desafio adicional. O risco é de alguém descobrir como vencer o primeiro desafio sem que também tenha vencido o desafio adicional de garantir uma segurança perfeita.

Eu acredito que deveríamos procurar uma solução antecipada para o problema do controle, para que esteja à mão quando precisarmos dela. Pode ser que não consigamos resolver o problema do controle antecipado talvez porque alguns elementos só possam ser colocados quando conhecermos os detalhes da arquitetura onde será implementado. Quanto mais antecipadamente resolvermos o problema do controle, maiores serão as chances de que a transição para a era da máquina inteligente será bem-sucedida.

Para mim, parece algo que vale a pena ser feito e posso imaginar que se as coisas correrem bem, e as pessoas daqui a 1 milhão de anos se lembrarem deste século, pode ser que elas digam que a única coisa que fizemos e que realmente valeu a pena foi fazer isso do jeito correto.

Obrigado.

iBest: 247 é o melhor canal de política do Brasil no voto popular

Assine o 247, apoie por Pix, inscreva-se na TV 247, no canal Cortes 247 e assista:

Comentários

Os comentários aqui postados expressam a opinião dos seus autores, responsáveis por seu teor, e não do 247